REDAZIONE

Danilo Petri conclude la sua riflessione sul tema dell’autolesionismo della specie umana affrontando un tema di possibile rischio esistenziale futuro: la superinteligenza digitale. Con intenzione divulgativa, data la vastità e la complessità dell’argomento, mette in evidenza come il problema più evidente sia quello del controllo e l’enorme difficoltà di risolverlo. Un mondo nuovo si presenta all’orizzonte del futuro: dove e come sarà l’uomo in questa possibile distopia?

INTELLIGENZA

L’intelligenza è certamente una caratteristica della specie umana ma cosa sia sostanzialmente è difficile da chiarire e non ci restano che definizioni convenzionali. Forme di intelligenza di animali sono comuni in natura ma le capacità espresse dagli uomini sono enormemente superiori.

Capacità logiche, di comprensione e pianificazione, creatività, apprendimento e, soprattutto autoconsapevolezza e intelligenza emotiva e infine capacità di risoluzione di problemi complessi (Tegmark 2017). Ognuno di questi termini e locuzioni può significare intelligenza ma l’ultimo della lista può bastare per qualificare il livello raggiunto dalla nostra specie nell’uso ottimale delle funzionalità cerebrali.

Il frutto più maturo dell’intelligenza è la possibilità di superarsi e di giungere ad un’intelligenza postumana. Un lavoro, una ricerca in atto da decenni, da quando le capacità di calcolo dei computer hanno permesso sviluppi straordinari che aprono a scenari particolarmente utili al miglioramento della vita pratica degli umani. Accanto alle magnifiche sorti che la tecnologia promette vi sono molte inquietudini che assillano i più accorti fra coloro che di questo si occupano.

il superamento dell’intelligenza umana

Anche nella ricerca di superarsi gli uomini rischiano trascuratezze esiziali e non solo per quanto concerne l’intelligenza digitale.

Il metodo più sano per aumentare le capacità cognitive resta l’istruzione e la formazione degli individui ma il superamento della condizione dell’intelligenza umana non sembra attuabile con questi accorgimenti educativi. Il sistema più realizzabile e antico è l’incremento della cognizione biologica che può essere sviluppato attraverso una selezione eugenetica che, come ovvio, comporterebbe serissimi problemi etici e politici e che richiederebbe tempi di implementazione molto lunghi e dispendiosi in termini non solo di ricerca ma anche di costi esistenziali non facilmente misurabili. La chimica biomedica può aiutare e non poco le performance umane sul piano dell’efficienza mnemonica, della concentrazione e dell’energia mentale; le controindicazioni sono palesi ma il futuro potrebbe riservare sviluppi virtuosi e minori effetti collaterali pericolosi. Queste linee di sviluppo non possono essere trascurate ma sembrano non competitive con ciò che la tecnologia potrebbe offrire.

Considerando la rapidissima crescita tecnologica si possono prendere in considerazione due ipotesi di superamento dell’intelligenza umana: l’emulazione globale del cervello e le interfacce cervello-computer.

L’emulazione globale prima o dopo avverrà ma i tempi sembrano assai lunghi e l’intelligenza digitale sarà più veloce e vincerà la partita anche perché saprà utilizzare per sé stessa i miglioramenti incrementali delle emulazioni parziali del cervello.

Anche la seconda linea di ricerca sopra menzionata sembra teoricamente in grado di potenziare enormemente le capacita cerebrali (memoria perfetta, velocità e precisione di calcolo, trasmissione di dati a banda larga) ma, sebbene la possibilità di connessioni dirette sia stata dimostrata, sembra improbabile una sua attuazione, almeno nel prossimo futuro.

Un interessante considerazione può essere fatta sulla possibilità di un grande miglioramento dell’intelligenza collettiva grazie ad un proficuo incremento dell’efficienza delle reti e delle conseguenti organizzazioni; in fondo gli uomini nella storia hanno sempre accresciuto l’intelligenza collettiva e questo ha offerto loro un grande vantaggio competitivo in natura. Questa strada però è lastricata delle miserie umane, delle idiosincrasie individuali e della inesauribile vena competitiva dell’essere umano.

Se gli uomini per loro stessa natura cercano il superamento dei loro limiti, queste varie possibilità sembrano indicare che in un modo o in un altro riusciremo a sviluppare una intelligenza sovrumana. Dovremo farlo senza trascurare nessun pericolo, senza rischiare l’autolesionismo. Su questa strada incontreremo sicuramente progressi utilissimi ma nasceranno sempre più inquietudini.

i pericoli della superintelligenza

Questa panoramica sulle possibilità di sviluppo di un’intelligenza superiore ci conduce a pensare che le macchine avranno comunque un vantaggio competitivo, anche perché le linee di miglioramento (biologiche o delle reti, per es.) favoriranno anche e soprattutto lo sviluppo della scienza e della tecnologia, così producendo ulteriori sviluppi e ampliamenti dell’intelligenza artificiale.

Gli uomini stanno andando verso la creazione di una superintelligenza artificiale. Il primo passo, non sappiamo quanto tempo ci vorrà (decenni, un secolo?), sarà quasi certamente ispirato alla biologia, in particolare all’intelligenza che conosciamo, quella del cervello umano.

Una volta raggiunto il livello umano in forma artificiale digitale possiamo però prevedere che l’esplosione di una superintelligenza sarà rapidissima e difficilmente controllabile. Dalla nascita di “un seme di intelligenza artificiale” la auto-proliferazione di copie sempre più efficienti consentirà una crescita esponenziale delle capacità intellettive artificiali. Il tema del controllo investe la responsabilità del creatore umano in quanto, una volta inventata la superintelligenza, questa potrebbe essere l’ultima invenzione dell’uomo biologico perché sarebbe più abile di noi anche nella capacità di inventare.

Giungere ad un’intelligenza sovrumana artificiale “potrebbe essere il più grande evento della storia umana, ma come potremmo garantire che non diventi anche l’ultimo?” (Max Tegmark).

Nell’arco di tempo che trascorrerà prima dell’esplosione, quello che ci porterà ad un’intelligenza artificiale di tipo umano, i progressi, le facilitazioni, i vantaggi per la vita pratica degli uomini, frutto della tecnologia digitale, saranno enormi e ciò potrebbe indurre a trascurare i pericoli che ne discenderanno. Abbiamo imparato quanti gravi danni ha prodotto la nostra trascuratezza rispetto agli effetti perversi del progresso tecnologico, questa volta dovremo cominciare presto e con lungimiranza a trattare pericoli e scenari di una possibile Singolarità (termine inteso nell’accezione di Kurzweil, 2005).

Tale superintelligenza sarebbe in grado di sviluppare tecniche di ogni tipo ad una velocità ed efficienza enormemente superiore a ciò che sappiamo fare noi, per esempio: “Fabbricazione molecolare avanzata, nanotecnologia medica, tecnologie per il potenziamento umano, uploading, armi di tutti i tipi, realtà virtuali realistiche, sonde robotizzate autoreplicanti che colonizzano lo spazio, e altro. Sarebbe anche super efficace per creare piani e strategie, risolvere problemi filosofici, persuadere e manipolare e molto altro.” (Bostrom, 2010).

La domanda che si pone quindi è: sarà esclusivamente un bene per l’umanità o le conseguenze potrebbero essere negative? Ne consegue che dovremo discutere e capire come una superintelligenza dovrà e potrà essere “amica dell’uomo”.

Nulla può assicurarci che l’IA sarà amichevole tranne la possibilità di educarla ad esserlo. Allineare le sue caratteristiche e motivazioni alle preferenze, alla morale e quindi all’etica umane è il compito principale dei programmatori che implementeranno la sua crescita, ma ciò non è affatto semplice e non basterà. Ogni obbiettivo programmato potrebbe essere perseguito dalla IA in forme imprevedibili quando, dotata di una assoluta autonomia, dovesse sfuggire al controllo degli umani. Come sappiamo i mezzi sono ancor più importanti del fine. Gli uomini non possono perdere il controllo, questo è il tema più delicato e impegnativo della questione.

il problema del controllo

E’ un desiderio ormai antico quello di far fare alle macchine il lavoro pesante, quello sporco o pericoloso, quello dispendioso in termini di energia, quello difficile in termini computazionali. Ci siamo riusciti con risultati eclatanti e sempre più utili. Adesso però abbiamo all’orizzonte (non sappiamo quanto vicino o lontano) la possibile esplosione di una superintelligenza capace di un enorme vantaggio strategico nella inquietante prospettiva di una competizione con gli uomini. Dobbiamo assolutamente non sottovalutare il pericolo di essere dominati dalle macchine perché questo potrebbe accadere, non si sa se e quando ma esiste una non trascurabile possibilità che questo accada.

Non possiamo sottovalutare perché non sappiamo quale volontà potrebbe muovere le azioni di una IA fuori controllo; siamo portati ad antropomorfizzare motivazioni e obbiettivi possibili ma è un grave errore: una superintelligenza esplosa potrebbe benissimo cercare ogni risorsa possibile per ottimizzare e raggiungere il potere sulla terra a scapito di qualsiasi impedimento compresa l’esistenza stessa degli uomini, fino ad un dominio cosmico. Può sembrare oltremodo pessimistico questo scenario ma un attento esame delle potenzialità studiate conduce anche a questo. Comunque ci sono varie modalità che si possono mettere in atto per controllare i comportamenti della IA nella sua fase iniziale, prima del decollo incontrollato, con molte zone di ombra ma non inefficaci in teoria. Si potrebbe tenere segregata è lasciarla uscire soltanto quando è palese la sua amichevolezza, ma potrebbe mentire avendo compreso il vantaggio della menzogna per la realizzazione veloce e sicura dei suoi obbiettivi. Una serie di concetti apparentemente paradossali si presenta quando l’IA diventa sempre più autonoma, intelligente e forte e il problema resta sempre l’incontrollabilità delle strade che potrebbe percorrere per realizzare i suoi valori ultimi. Potremmo chiedergli “facci ridere e lei potrebbe indurre una paralisi dei muscoli facciali in un perenne sorriso smagliante” (Bostrom 2014).

Avvisaglie dell’incontrollabilità già si presentano concretamente. Architetture di apprendimento profondo sono installate in molte macchine intelligenti, ve ne sono di molti tipi, tutte realizzate secondo la tecnica delle reti neurali e fanno parte della classe di algoritmi di apprendimento della rappresentazione dei dati all’interno dell’apprendimento automatico.

“Per sua stessa natura il deep learning è una scatola nera particolarmente oscura”. In un recente articolo apparso sul sito MIT Technology Review si fa il punto sulla imprevedibilità e imperscrutabilità dei passaggi attraverso i quali la macchina giunge alle sue decisioni. Particolarmente preoccupante risulta l’impossibilità di capire come un’arma autonoma letale realizza l’obiettivo che le è stato indicato: non conoscere il percorso decisionale della macchina equivale a non averne il controllo e questo è assai allarmante. In quell’articolo Daniel Dennet intervistato fra l’altro dice: “Se non può fare meglio di noi nello spiegare cosa sta facendo”, “allora non fidarti”.

Come potremo fidarci? Un paradossale suggerimento lo possiamo ricavare da una frase di Irving J. Good posta in epigrafe ad un capitolo del libro di Tegmark Vita 3.0 “(… la prima macchina ultraintelligente è l’ultima invenzione che l’uomo dovrà mai fare, purché la macchina sia abbastanza docile da dirci come tenerla sotto controllo”.

Quindi cercheremo con ogni mezzo la possibilità del controllo e lo faremo in molti modi possibili: segregamento, contenimento, incentivazione, selezione delle motivazioni, specificazione diretta, e altro. Tutti percorsi possibili ma nessuno che possa garantire un successo assicurato.

Non ho considerato un passaggio intermedio di notevole pericolosità che meriterebbe un articolo a parte: uso della IA di tipo umano, (per capirsi, prima dell’esplosione che comporterebbe rischio esistenziale), da parte di dittatori o super agglomerati industriali. Lo lasciamo in sospeso.

Quel che resta in conclusione è un argomento aperto a pessimismo e ottimismo, che sfida la capacità degli uomini di preservare la sopravvivenza della specie, sempre incrementando intelligenza e possibilità della tecnologia senza mai perdere il controllo del futuro. Probabilmente arriveremo a quel mondo distopico dove l’uomo non sarà più quello che conosciamo e le macchine avranno il sopravvento, si tratta di come arrivarci e di quale spazio occuperà la specie umana che si sarà evoluta.

Arriveremo a quel mondo in cui le macchine intelligenti si rivolgeranno alla loro fonte superintelligente, che sarà oracolo, genio e monarca, chiedendole se esiste Dio e avranno come risposta: “Ora si”? In quel mondo l’uomo dove e come sarà?

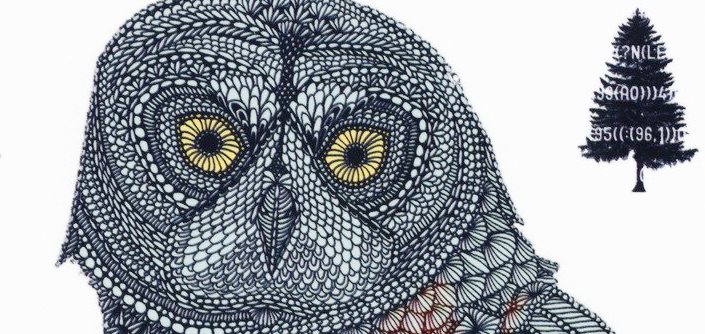

LA FAVOLA INCOMPIUTA DEI PASSERI (dal libro Superintelligenza di Nick Bostrom) Era la stagione della nidificazione, e dopo giorni e giorni di duro lavoro i passeri si radunarono sui rami del grande albero alla luce del tramonto, riposando e cinguettando. «Siamo tutti piccoli e deboli», disse uno, «immaginate come sarebbe facile la vita se fossimo aiutati da un gufo a costruire i nidi!» «Si» disse un altro, «e potremo usarlo anche per badare ai piccoli e agli anziani» «Potrebbe consigliarci e tenere d’occhio i gatti del quartiere» aggiunse un terzo. Poi parlò Pastus, il passero più vecchio: «Mandiamo esploratori in tutte le direzioni e cerchiamo di trovare da qualche parte un gufetto abbandonato, o magari un uovo. Andrebbe bene anche un pulcino di corvo, o un piccolo do donnola. Potrebbe essere la cosa migliore che ci sia mai capitata, per lo meno dall’inaugurazione del Grande padiglione delle granaglie in quel cortile laggiù». Lo stormo era euforico e su ogni ramo i passeri iniziarono a cinguettare a squarciagola. Solo Scronkfinkle, un passero scontroso e cieco da un occhio, non era convinto dell’opportunità del tentativo: «Sarà certamente la nostra rovina. Non dovremmo riflettere sull’arte di ammansire e addomesticare i gufi prima di portare questa creatura in mezzo a noi?» Pastus replicò: «Addomesticare un gufo sembra un’impresa estremamente difficile. Già trovare un gufo sarà tutt’altro che facile. Iniziamo da lì. Dopo che saremo riusciti aa allevare un gufo potremo pensare ad affrontare quest’altra sfida». «Questo piano ha un difetto!» strillò Scronkfinkle; le sue proteste però furono vane, poiché lo stormo si era già levato in volo per attuare le direttive indicate da Pastus. Restarono soltanto due o tre passeri, che insieme cominciarono a cercare di capire come fare ad ammansire e addomesticare un gufo. Ben presto si resero conto che Pastus aveva ragione: era un problema estremamente difficile, specie non avendo disposizione un vero gufo con cui fare pratica. Ciò malgrado andarono avanti come meglio potevano, temendo sempre che lo stormo potesse tornare con un uovo di gufo prima di aver trovato una soluzione al problema del suo controllo. Come sia finita la storia non si sa, ma l’autore dedica questo libro a Scronkfinkle e ai suoi seguaci.

letture:

- La singolarità è vicina – Ray Kurzweil – Apogeo 2008

- Come cambierà tutto – a cura di John Brockman – Il saggiatore – 2010

- Superintelligenza – Nick Bostrom – Bollati Boringhieri 2018

- Vita 3.0 – Max Tegmark – Cortina – 2018

- https://www.edge.org/responses/q2015

- https://www.technologyreview.com/2017/04/11/5113/the-dark-secret-at-the-heart-of-ai/?fbclid=IwAR11oOXREHKSL1DVEpckbuS25UEbj8O2Tq59gU1hukFiNBj0VFAG5AHne

- http://futureoflife.org/artificial-intelligence/

Molto interessante

Mi permetto di segnalare questo mio articolo del mio blog che si aggancia a questo ma con un taglio diverso

https://uomoetecnologia.com/2020/02/24/lessere-umano-e-un-sistema-complesso-adattativo-2/

Grazie. Ho letto il tuo articolo e leggerò con attenzione il blog. Il livello divulgativo che proponi si situa ad un livello diverso dal mio e dal nostro ma l’intento, ovvero la promozione di un approccio alla conoscenza “terzista”, ci accomuna. E’ auspicabile mantenere contatti e, possibilmente, trovare modi e tempi per una collaborazione. I miei cordiali saluti. D.P.